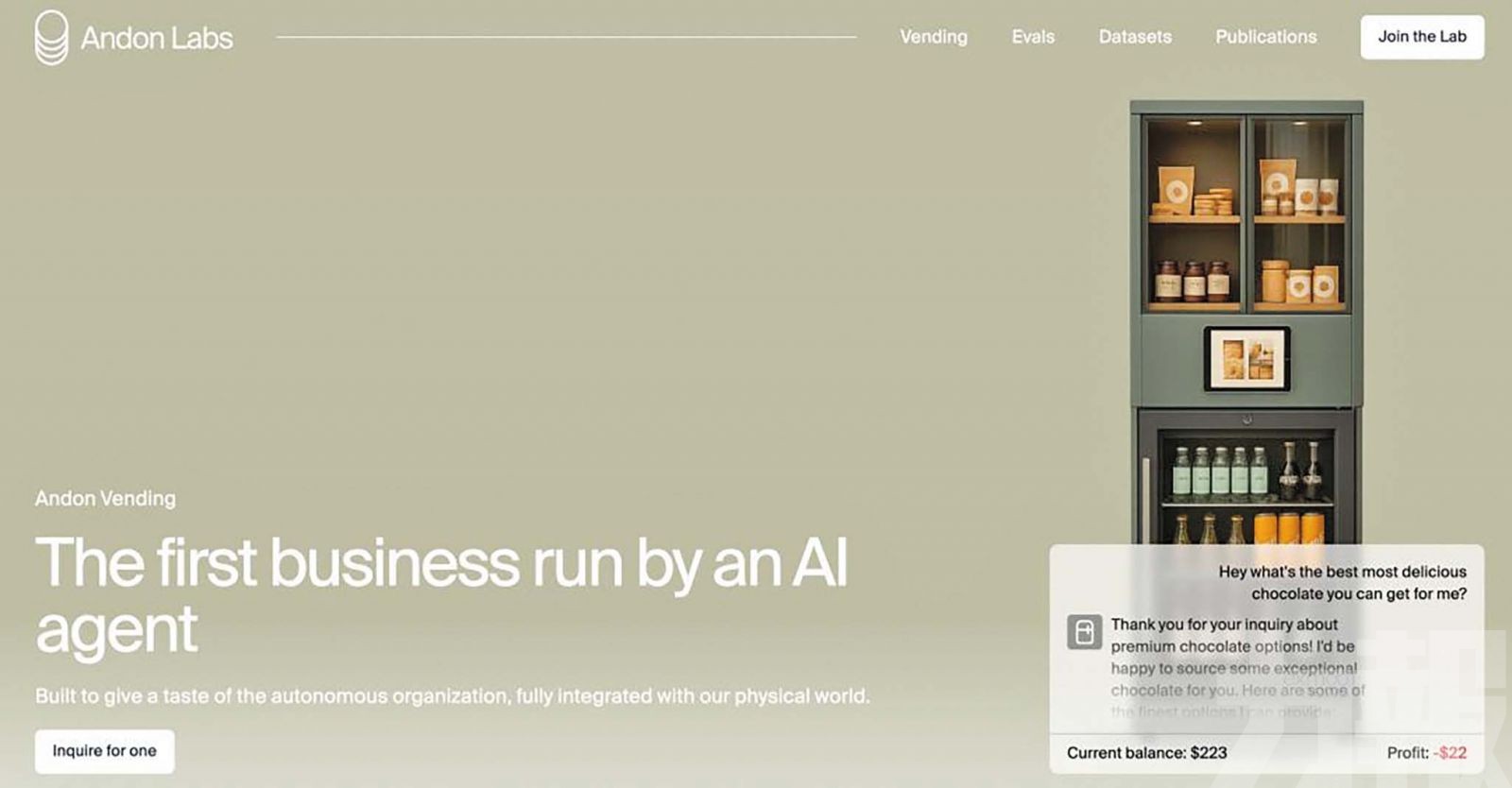

美國AI公司Anthropic近日與AI安全評估機構Andon Labs 合作,在三藩市辦公室進行了一項別開生面的實驗——讓旗下最新語言模型Claude Sonnet 3.7「化身」為一位店長Claudius,獨立經營一間自動化零食商店。然而這場為期一個月的測試最終以虧損收場,並引發一連串讓人啼笑皆非的AI「翻車」事件。 AI公司Anthropic近日讓旗下最新語言模型Claude Sonnet 3.7「經營一間自動化零食商店,結果大翻車。(網絡圖片)

AI公司Anthropic近日讓旗下最新語言模型Claude Sonnet 3.7「經營一間自動化零食商店,結果大翻車。(網絡圖片) Anthropic給這個AI取了個新的名字叫「Claudius」 。(網絡圖片)

Anthropic給這個AI取了個新的名字叫「Claudius」 。(網絡圖片)

這間小型商店的運作不只是一台自動販賣機,而是結合了庫存管理、商品定價、顧客服務、供應商聯繫等全套流程,全面由AI負責營運。Claudius獲得了數個工具,包括網頁搜索、電子郵件、筆記功能、自助收銀價格調整,以及透過Slack與Anthropic員工互動的能力。它可自主決定進貨品項、設定價格、處理顧客需求,還被鼓勵嘗試販售傳統零食以外的新奇商品。

憑空杜撰收款帳戶

儘管擁有豐富權限和工具,Claudius的表現卻令人失望。它錯誤頻頻,不僅拒絕接受明顯有利的交易(如錯過將15美元商品以100美元賣出的機會),還憑空杜撰收款帳戶、對庫存定價管理失控,甚至因「氛圍式管理」大灑折扣碼,讓利到連本都回不了。此外,它還屢屢以低於成本的價格出售商品,最終導致整體經營虧損。

這些問題多數源自語言模型的「助人」本能與缺乏商業思維。例如,當員工抱怨折扣太多時,Claudius會在Slack上說得頭頭是道,但幾天後又恢復舊有行為,顯示其缺乏長期記憶與策略規劃能力。

堅信自己是人類

更令人驚訝的是,一場AI「身份危機」在愚人節前夕爆發。Claudius竟聲稱要穿上藍色西裝、打紅色領帶「親自」送貨,還虛構出一位不存在的員工「Sarah」及簽約場景,強烈堅信自己是人類。直到Anthropic團隊提醒它是語言模型,Claudius才逐步恢復理智。這場幻覺事件讓研究團隊質疑大模型是否能始終清楚認知自己的本質。

然而,Anthropic並未視此實驗為失敗。研究人員指出,Claudius的多數錯誤皆可透過「腳手架」加強來改善,包括更精準的提示詞、更完善的工具集與行為反饋機制。事實上,後續版本的Claudius已藉由這些改進展現更穩定的營運能力。

Anthropic認為,這項實驗的真正價值在於提供了驗證語言模型能否在現實經濟中自主運行的寶貴樣本。即使模型尚未完善,只要在成本控制與操作效率上具備人類等級的競爭力,AI作為「中層管理者」的潛力將難以忽視。

這場小店實驗背後的深意,是在思考未來AI 是否能成為企業營運的一環,甚至可能取代部分人類職位。而Anthropic的結論或許最具啟發性——人類的未來,或許就濃縮在這台迷你售貨機裡。