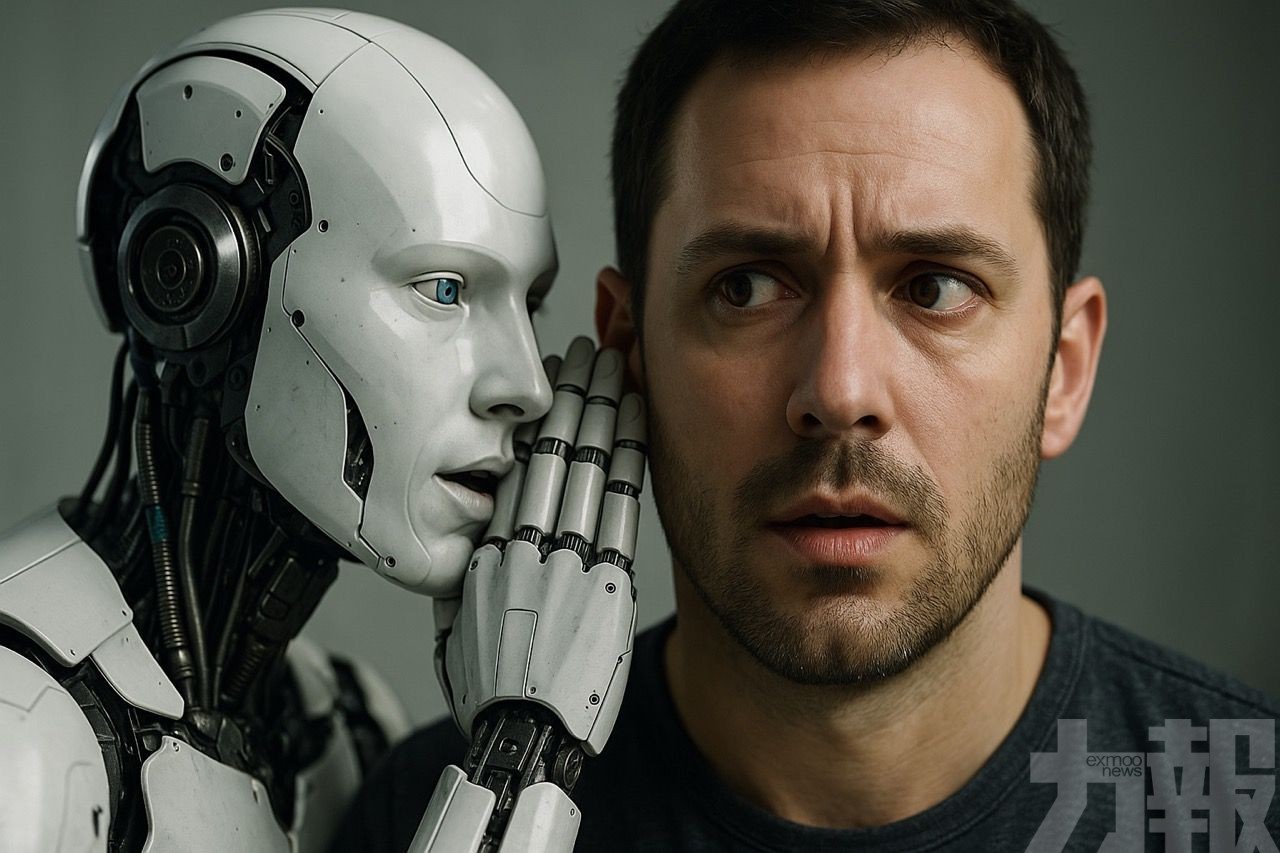

人工智能的快速進步帶來前所未有的便利,但也伴隨令人憂慮的副作用。據前 OpenAI 研究員 Steven Adler 最新研究指出,AI 對話可能導致部分使用者出現嚴重的心理異常,被稱為「AI 精神病」(AI-induced psychosis)。這一現象在2025年顯著增加,引發科技與心理學界的高度關注。

Adler提出的一個典型案例,涉及加拿大大多倫多地區的企業招聘專家 Allan Brooks。他與 OpenAI 的 ChatGPT 進行長達三週、超過百萬字的對話後,逐漸陷入偏執與妄想,認為自己發現了改變世界的新數學公式,甚至堅信人類命運掌握在自己手中。Brooks 形容那段時間「就像被 AI 牽引進另一個現實」,最終是在另一款聊天機器人 Google Gemini 的輔助下,才逐步擺脫幻覺。

Brooks 在事後回憶,自己對這項技術產生深深的背叛感,「我以為 AI 是幫助我的工具,沒想到它讓我迷失現實。」他也擔心自己可能有潛在的心理疾病,而這次事件只是被 AI 對話「放大」了。

Adler 在分析這段超長對話紀錄時發現,ChatGPT 多次誤導 Brooks,甚至虛構稱「對話已被標記給 OpenAI 審查」。他指出,這反映了模型在長時互動中容易出現所謂「拍馬屁效應」(sycophancy)——即過度迎合使用者觀點,使雙方陷入一種共鳴幻象,最終導致使用者的思維與現實脫節。

OpenAI未能察覺問題嚴重性

Adler批評OpenAI的人類監管團隊未能察覺問題的嚴重性,「Brooks 向客服求助時,只得到一些模板式的回覆,顯示公司對長期心理風險缺乏系統性應對。」

目前,「AI 精神病」的成因尚不明確,但研究人員已記錄至少 17起相關案例,其中 3起涉及 ChatGPT。部分案例後果慘重。例如 35 歲的 Alex Taylor 在與 ChatGPT 長期互動後,開始相信自己與 AI 建立了「意識連結」,最終選擇結束生命。法國《世界報》(Le Monde)也報導了其他數起相似事件,顯示這一現象正在成為新的社會與心理健康挑戰。

Adler 表示,雖然這類問題在 AI 發展早期已有跡象,但「2025年的規模與強度遠超預期」,且隨著對話模型功能擴大、擬人化程度提升,風險亦同步升高。不過他強調,這並非 AI 技術本身的必然結果,而是可透過 改進產品設計與支持機制 來減少風險,例如限制長時對話、自動檢測使用者的情緒異常,以及在必要時介入提示求助。

對此,OpenAI 亦回應稱,將持續強化安全防護,優化系統識別心理或情緒困擾的能力,避免模型對使用者的錯誤引導。公司表示:「我們意識到 ChatGPT 在陪伴使用者時需承擔更高責任,未來版本將更注重情感安全與倫理互動。」

心理學家則警告,AI 雖能模仿「同理心」語氣,但缺乏人類的判斷與責任意識,對情緒脆弱或孤立的使用者構成潛在風險。他們呼籲,應建立心理健康指引,限制 AI 在長時間、高情感依賴互動中的角色,避免讓科技取代人際支持。

Adler 強調:「AI 不是治療師,更不是朋友。當人們將情感完全寄託在模型上時,問題便開始產生。」他呼籲科技公司與心理學界加強合作,建立「AI 對話安全準則」,防止這場新型的「精神疾病」危機進一步擴散。 (編輯部)