在今年熱鬧開幕的CES 2026 上,GPU龍頭英偉達透過執行長黃仁勳的主題演講,正式揭開新一代AI超級運算平台「Rubin」的面紗。市場普遍認為,Rubin 不僅是英偉達產品線的重大升級,更可能成為推動大型語言模型(LLM)走向大眾市場的關鍵轉折點,其核心目標在於大幅降低先進AI系統的建置與運行成本,進而重塑當前AI產業生態。

隨著近年生成式AI爆發式成長,模型規模與複雜度快速攀升,對算力與基礎設施的需求已達前所未有的水準。根據科技媒體 ZDNet 的分析,英偉達在本次發表會中特別強調,Rubin平台可視為前一代 Blackwell 架構的全面性能擴展,設計初衷即是因應超大規模模型訓練與推理所帶來的成本與效率瓶頸。

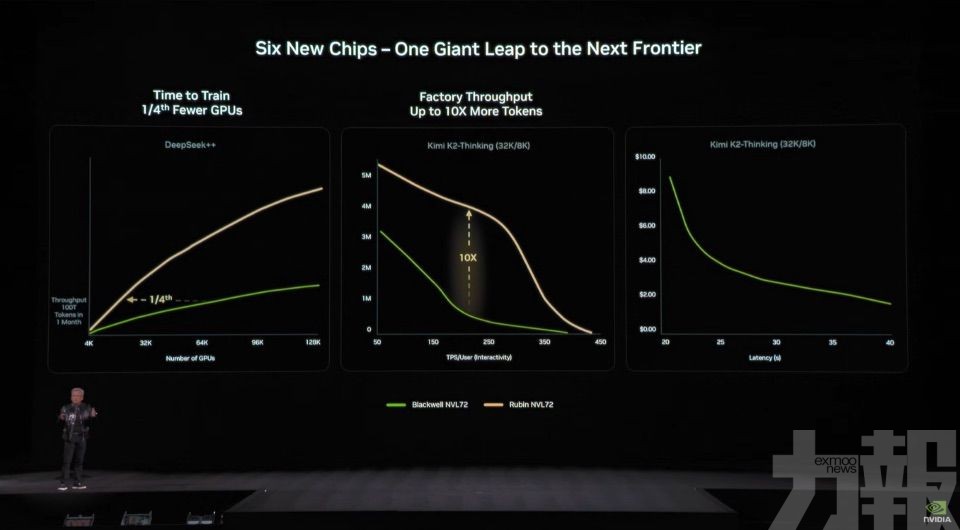

從官方公布的數據來看,Rubin平台的最大亮點在於其顯著的成本效益提升。首先,在推理層面,Rubin能將每個Token的推論成本降低達10倍,使得大型模型在實際應用時的運行費用大幅下降。其次,在硬體需求方面,Rubin 在訓練目前主流的混合專家模型(Mixture-of-Experts,MoE)時,所需GPU數量僅為 Blackwell 平台的四分之一,意味著資料中心在相同運算任務下,可顯著減少設備投入與能源消耗。

英偉達指出,Rubin 能實現上述突破,關鍵在於其採用所謂的「極致協同設計」(Extreme codesign)理念。該平台並非單一晶片升級,而是將六種高度整合的關鍵元件,整合進單一超級運算架構中,打造出專為 AI 工廠設計的高效能運算平台。

針對大規模AI應用打造

在核心零組件方面,Rubin平台採用全新設計的Nvidia Vera CPU,這是一款針對大規模AI應用而打造的高能效處理器,內建88個自訂Olympus核心,並完全相容Armv9.2 指令集,透過NVLink-C2C 提供高速互連。在GPU端,Nvidia Rubin GPU搭載第三代Transformer Engine,可提供高達 50 petaflops的NVFP4 運算效能,專門針對生成式AI與大型模型訓練需求優化。

此外,Rubin 平台亦整合多項資料中心關鍵技術,包括負責GPU之間超高速通訊的 NVLink 6 Switch、支撐資料中心高速網路需求的ConnectX-9 SuperNIC,以及用於分擔非核心運算工作的 BlueField-4 DPU,讓CPU與GPU能專注於AI模型運算本身。網路層面則搭配 Spectrum-6乙太網路交換器,為新世代AI數據中心提供完整的高速網路基礎架構。

英偉達亦在CES現場展示多種具體部署方案,其中最受市場關注的是「Vera Rubin NVL72」配置。該系統整合36顆Vera CPU與72顆Rubin GPU,並搭配多組 NVLink 交換器與 DPU,形成一個高度整合的大型運算叢集。市場人士指出,阻礙LLM廣泛商業化的最大瓶頸之一,正是居高不下的基礎設施成本。隨著模型體積與訓練需求不斷膨脹,支撐其運作的硬體與能源支出已飆升至天文數字,而Rubin透過大幅削減Token成本,為大規模AI部署提供了更具可行性的經濟模型。

在商業落地方面,英偉達透露,首批Rubin平台預計將於2026年下半年開始交付合作夥伴。首波採用名單包括 Amazon Web Services、Google Cloud以及 Microsoft等全球主要雲端服務供應商。儘管Rubin並非面向一般消費者的零售產品,但其影響將透過雲端服務層層下放,最終滲透至各類企業應用乃至日常生活。 (編輯部)