隨著全球人工智能(AI)進入兆級(gigascale)時代,資料中心的能耗、密度與計算能力正以驚人速度提升。英偉達(NVIDIA)在2025年全球開放運算高峰會上宣布多項關鍵技術突破,展示其在AI資料中心領域的最新成果,並推出下一代Vera Rubin架構,預計於2026年下半年問世,為AI推理與情境運算帶來革命性進展。

英偉達(NVIDIA)在2025年全球開放運算高峰會上宣布多項關鍵技術突破。 (網絡圖片)

英偉達(NVIDIA)在2025年全球開放運算高峰會上宣布多項關鍵技術突破。 (網絡圖片)

英偉達表示,在現有架構下,其GB200資料中心在短短兩個月內,對開源AI模型GPTO OSS的性能提升達五倍。這使每百萬個token 的運算成本,從11美分大幅降至僅2 美分。

根據Semi Analysis的推理測試,搭載NVL72系統的GB200在執行Deepseek R1模型時,比同級H200系統性能高出15倍,直接推動資料中心營收增長。這一成果標誌著AI運算成本與能效的重大躍進。

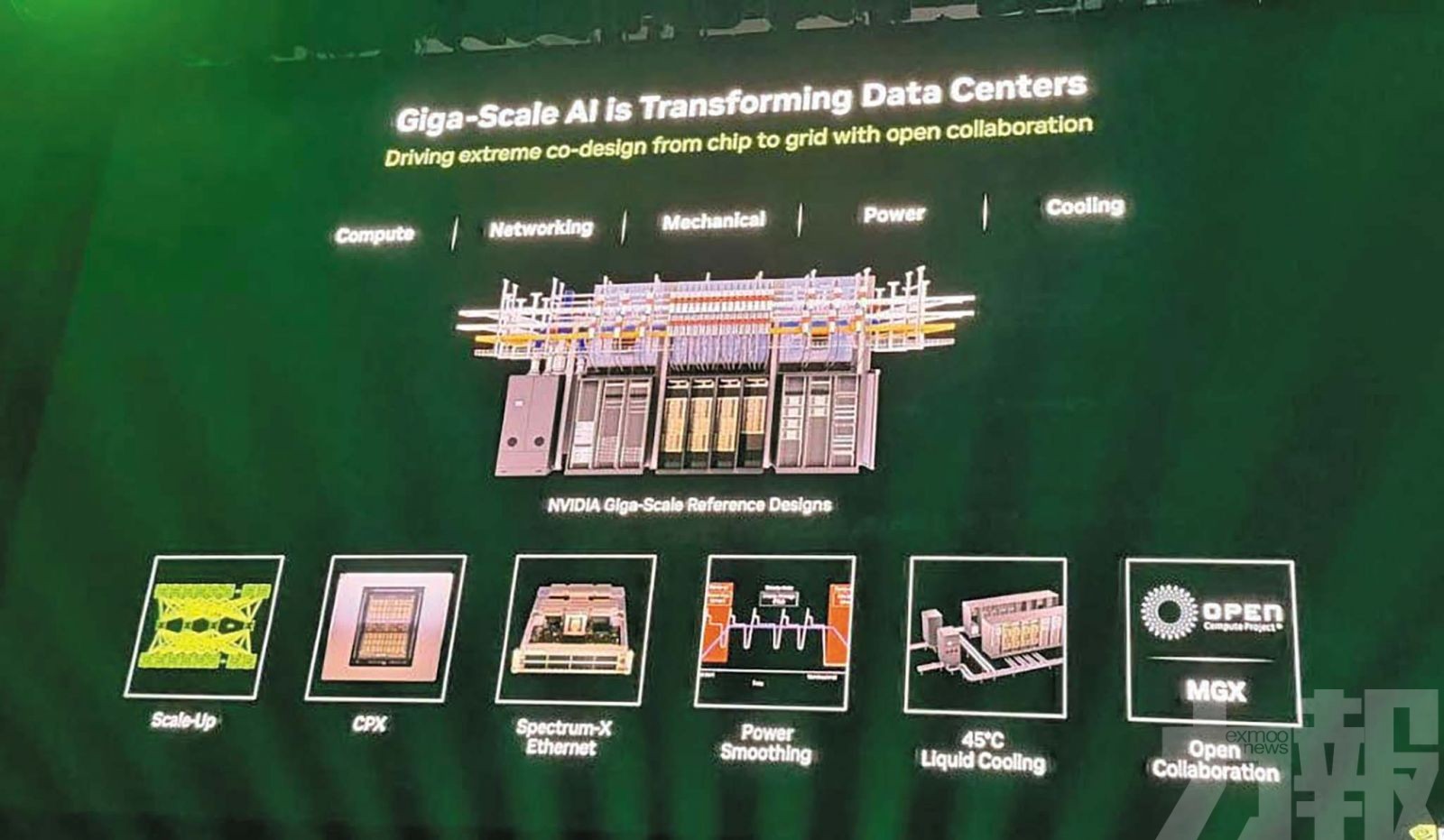

同時,英偉達在OCP(開放運算計畫)架構中全面升級機架智慧化、電力傳輸效率與互連技術,構建出可自我優化、持續升值的新一代智能資料中心。

模型情境化推理成AI新挑戰

英偉達指出,AI模型的複雜性正以指數級成長,從早期Llama 3模型需約1萬個AI核心,到新一代HSCR1與GPTO OSS模型需高達1,000萬個核心。這種規模提升反映了「混合專家」(Mixture of Experts)架構的普及與應用場景的多元化。

未來AI推理的關鍵在於「情境」——模型在生成第一個答案前,需先吸收並分析龐大的資訊量。英偉達預測,未來應用可能需處理逾百萬個token才能產生回應,這對電影製作、媒體生成、編程輔助等高價值應用領域至關重要。多媒體生成市場預計將從當前約40億美元,於十年內成長至400億美元。

雙晶片架構引領AI推理革命

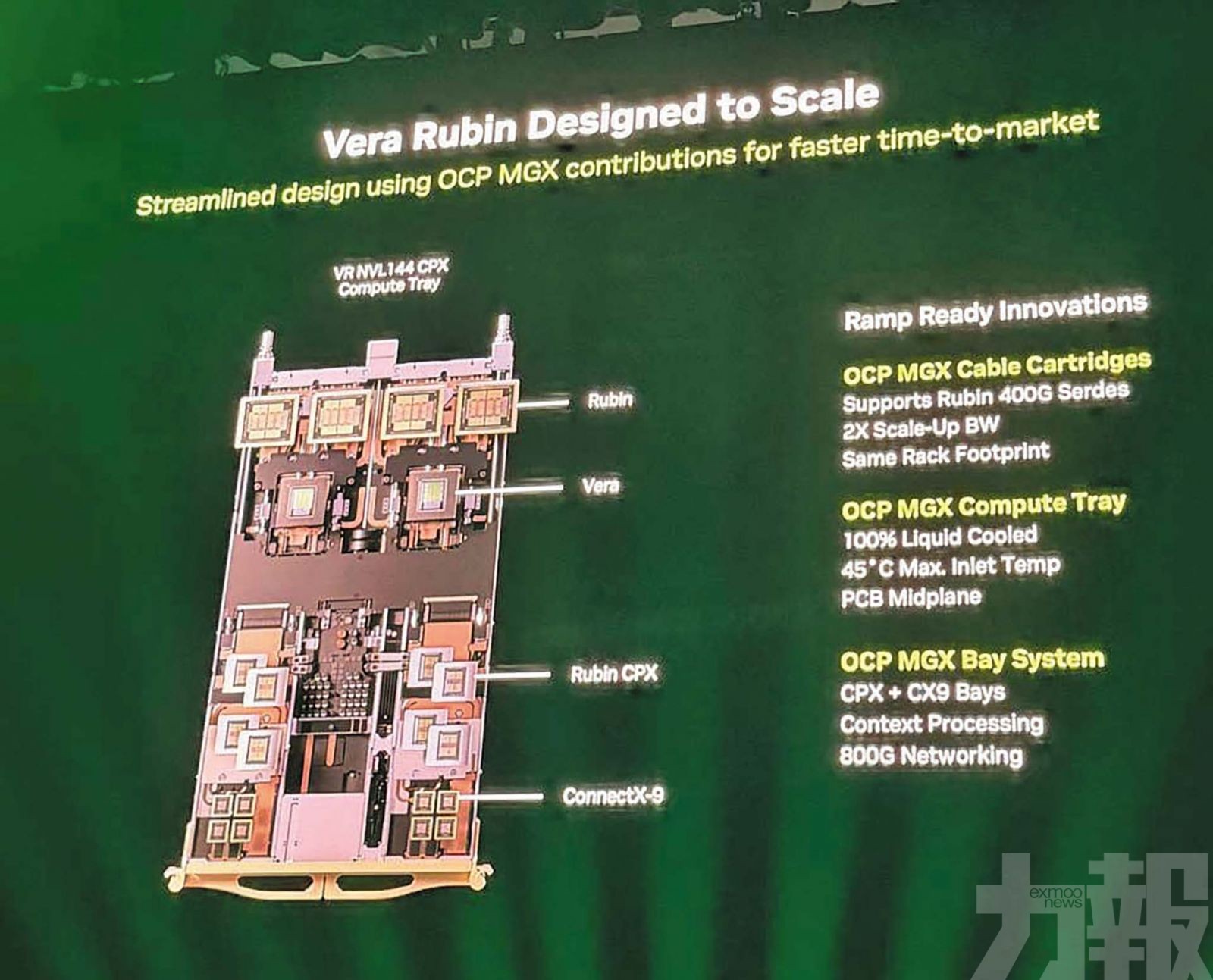

為應對AI情境處理挑戰,英偉達宣布推出全新Vera Rubin架構,兼容現有GB200與OCP基礎設施。該架構採 雙晶片設計——其中CPX處理器專責情境學習,具強大計算能力但低頻寬需求;Ruben GPU則聚焦推理與訓練性能。

Vera Rubin推理效能達 8 exaflops,較GB200提升7.5倍,並搭載更大記憶體。網路頻寬升級至 400G Scale Up,跨GPU總頻寬達 260TB/秒,為前代兩倍。

該系統全面支援OCP NGX水冷機架,採 100%液冷設計,可沿用GB200的45°C磁性入口溫度與現有冷卻設備,降低能源成本。MGX 機架亦升級至500安培匯流排與自動切換系統,提高能源效率與運行彈性。英偉達同時推出 NVLink Fusion 技術,實現CPU與GPU間的異構運算深度整合。

英偉達宣布多項合作計畫:富士通(Fujitsu)的Monaka處理器將採用NVLink Fusion協議與英偉達GPU整合;英特爾(Intel)將生產Fusion兼容CPU;三星(Samsung)加入英偉達現有合作夥伴生態(包括Alchip、Alstera與MediaTek),協助開放社群加速晶片整合。

此外,Meta已將採用 Spectrum XP 與 FBOSS 系統的Miniack 3N交換機貢獻給OCP;微軟Fairwater資料中心則運行於Spectrum X與OCP SONiC之上,成為全球最大AI超級電腦之一。甲骨文與OpenAI聯合打造的「星際之門(Stargate)」超級資料中心,也採用英偉達Spectrum與OCP技術,達成 95%頻寬利用率與零延遲運行。