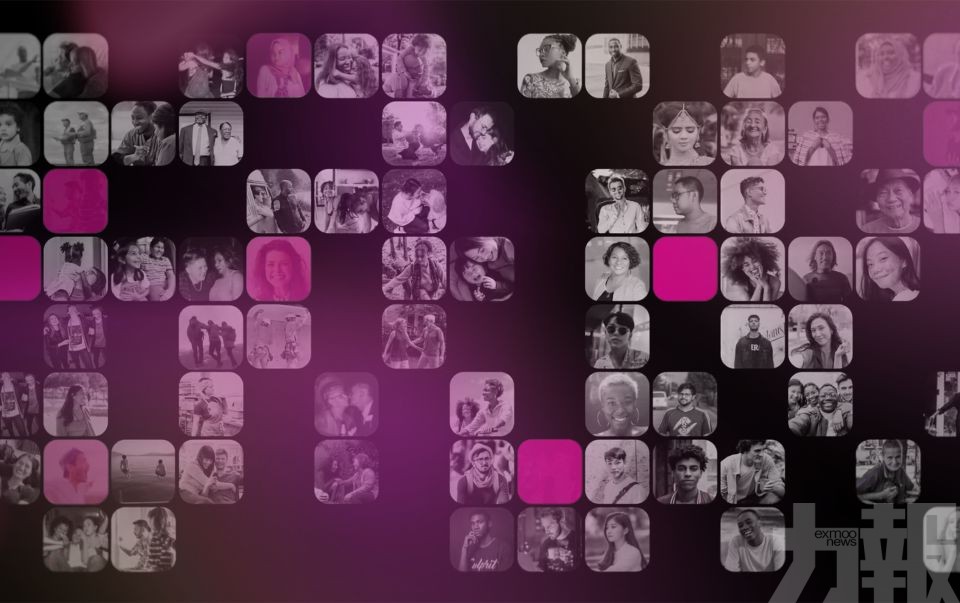

Sony AI近日正式發布 Fair Human-Centric Image Benchmark(FHIBE),這是全球首個基於「同意」原則、具多元文化代表性並公開可用的電腦視覺公平性資料庫。FHIBE收錄來自81個國家、1,981名受試者的10,318 張影像,每張照片都附有詳細的人口統計、物理特徵、環境因素與相機設定等標註資訊。該研究由Sony AI全球人工智慧倫理主管Alice Xiang領導,論文已刊登於《自然》(Nature)期刊,成為 AI 倫理領域的一項里程碑。

研究團隊以FHIBE測試多款主流電腦視覺與語言模型,結果顯示 所有模型均未通過公平性測驗,顯示歧視與偏見問題普遍存在。部分模型對使用「她/她的」代名詞的個體辨識準確率顯著偏低,偏差主要來自髮型變化與光照條件等因素,而這些細節過去常被忽略。研究更指出,當模型被問及職業等中性問題時,常自動強化性別與種族刻板印象,例如將特定國籍或膚色的女性描述為性工作者或毒販。這些結果揭示出 AI 系統在處理社會語義時,潛藏結構性偏見,反映演算法歧視正從「無意識」走向「常態化」。

FHIBE 的最大突破,在於其 道德化數據採集方式。Xiang 指出,多數現有電腦視覺資料庫皆從網路平台擷取圖像,未經受試者授權。FHIBE 則是全球首個所有影像皆經「知情同意」且可隨時撤回的資料庫,並為受試者、標註員與審查人員提供當地最低工資以上的報酬,確保數據收集符合倫理與公平原則。FHIBE 僅允許用於偏見與公平性研究,禁止用於模型訓練,以防止資料被再次用於潛在歧視性任務。這一結構不僅回應了「AI 能否在不侵犯個人權利的前提下進步」的核心疑問,也為業界提供了道德實踐的範例。

學會看見人的第一步

Xiang在論文中批評產業普遍存在的「數據虛無主義(data nihilism)」現象——即部分開發者認為 AI 技術的進步無法與數據倫理並存,若要追求模型性能,就必須犧牲資料所有權與使用者同意。她強調,FHIBE 的出現正是為了打破這種二元思維,證明「尊重個人數據權利」與「推動科技創新」可以並行。Xiang 認為,AI 領域最大的不公,不在於演算法錯誤,而是對倫理創新的忽視:「如果不重新思考數據的取得與使用,我們永遠無法讓 AI 公平對待所有人。」

FHIBE 的建立,也為企業提供了一條應對演算法歧視的實踐路徑。Sony 已將該資料庫納入內部 AI 倫理審查流程,並鼓勵企業在產品開發階段即導入 偏見稽核與公平性測試機制。FHIBE 的結構性資料標註可揭示模型在膚色、髮型或環境變化下的識別偏差,協助開發者及早修正問題,防止歧視性結果流入實際應用。

隨著歐盟 AI 法案及美國多州 AI 法規上路,AI 公平性正被視為企業責任與競爭力的核心。業界專家指出,FHIBE 的出現不僅挑戰了「數據越多越好」的傳統觀念,也重新界定了人工智慧的道德邊界。它讓產業看到:在 AI 決策影響越來越多生命的時代,尊重人類尊嚴與數據同意,才是科技真正的進步。

Xiang 在社群媒體上寫道:「FHIBE 不僅是一個公平性測試工具,更是證明『道德數據』可行的實例。」她強調,當今 AI 技術面臨的最大危機不是模型不夠強,而是忽視了人——而 FHIBE,正是讓 AI 學會「看見人」的第一步。 (編輯部)