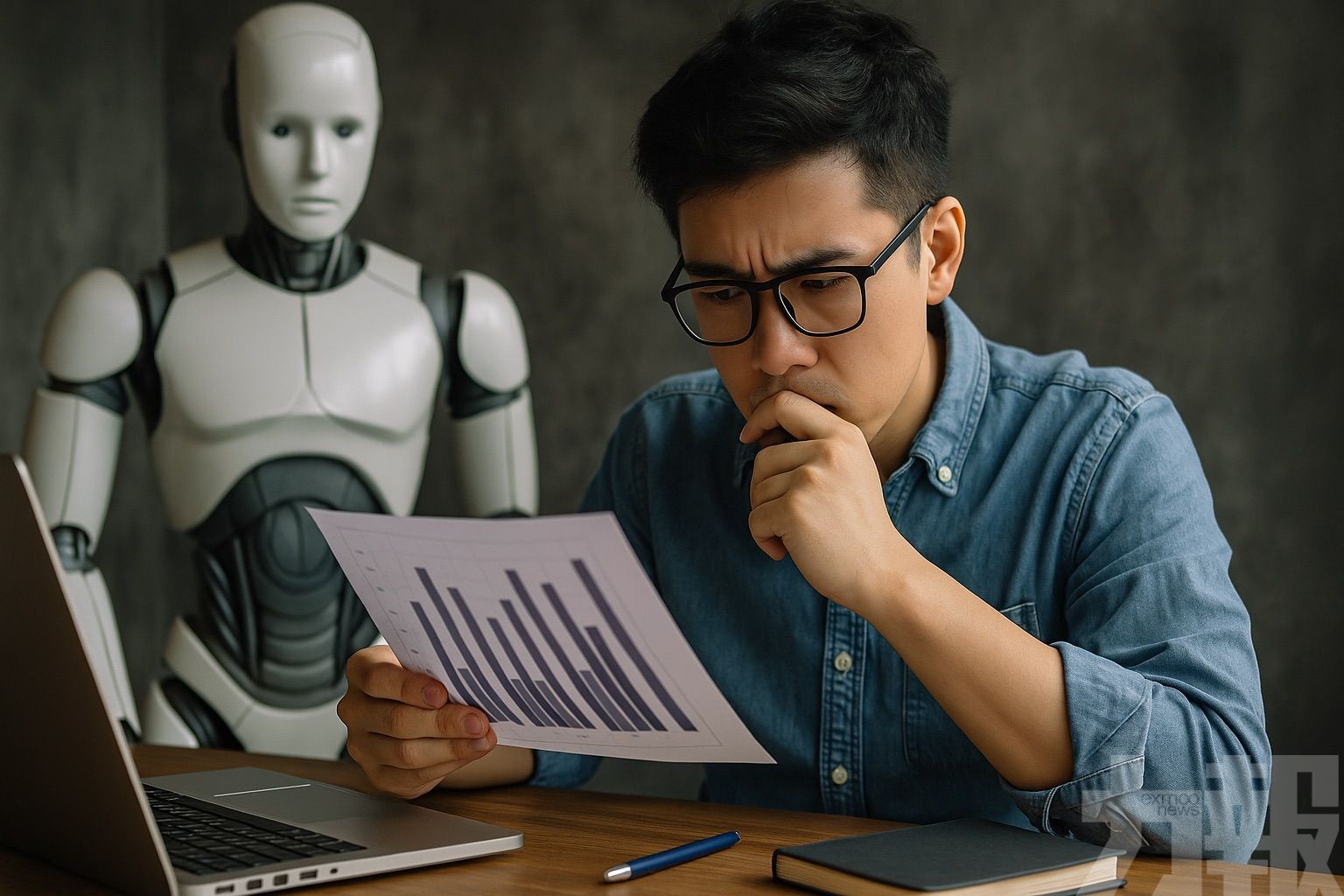

人工智能(AI)發展迅猛,大型語言模型(LLMs)屢次在各項基準測試中創下亮眼成績,展現出近似人類的理解與表達能力。然而,來自麻省理工學院(MIT)、哈佛大學與芝加哥大學的研究團隊近日發表研究,提出「波坦金理解」(Potemkin Understanding)一詞,指出這些模型可能只是在模仿理解,實則缺乏真正的概念掌握,對人工智能的發展方向帶來深遠啟示。

所謂「波坦金理解」,借用了18世紀俄羅斯軍事領導人波坦金為討好凱瑟琳二世而建造的虛假村莊作為隱喻,用以形容AI模型在標準測試中雖有高分表現,實則未能理解背後概念,僅是重複數據中的統計規律,形成虛有其表的假象。

哈佛博士後研究員瓦法(Keon Vafa)表示,這種理解假象與常見的「AI幻覺」不同,後者偏向錯誤生成或事實誤判,而波坦金理解反映的是模型對人類語義、邏輯結構、概念抽象等理解能力的缺失。該研究將於2025年國際機器學習大會(ICML)正式發表,並已引起學界廣泛關注。

僅是模仿人類行為

研究團隊針對文學修辭、博弈論、心理偏誤等領域,自行設計一系列更具挑戰性的概念測試。雖然目前主流模型能夠正確辨識定義或解釋術語,但在應用與延伸情境中卻顯得力不從心。例如,當模型被要求解釋「ABAB韻律」時能作出準確描述,但進一步要求其創作四行詩時,往往出現韻腳錯誤,顯示其理解未能轉化為實際操作能力。

統計顯示,模型在分類概念實例、生成範例與修改示例等任務中,錯誤率高達40%至55%。研究人員指出,這代表模型僅透過資料訓練所學得的語言關聯性,並不等於對語意概念的真正掌握。換言之,人類的理解行為在模型中只是被模仿,而非真實重現。

這一現象也讓AI基準測試的效度備受挑戰。既然模型能在缺乏理解的情況下取得高分,那麼現行測試方法可能過於表面,無法有效評估模型是否具備真正的通用智能能力(AGI)潛力。研究團隊呼籲,應開發更具深度與多層次的新型評估機制,才能避免誤導性的技術樂觀。

表面理解的風險

更值得注意的是,這種表面理解的假象可能對AI應用領域帶來潛在風險。以醫療為例,若診斷模型僅根據大量病歷資料進行統計推論,卻無法理解病理邏輯與病症變異,就可能導致誤診、漏診等後果,對使用者安全構成威脅。

研究團隊指出,消除波坦金現象將是通往AGI的必要一步。這意味著未來AI技術的發展,需不僅聚焦於數據規模與計算效能,更需強化對「理解」本身的技術定義與評估方式。他們亦提醒產業界與大眾,須警惕過度炒作,避免將現階段的語言模型誤認為具備人類水平的智慧。 (編輯部)